静的ファイルの配信を Google Cloud Storage に移行しました

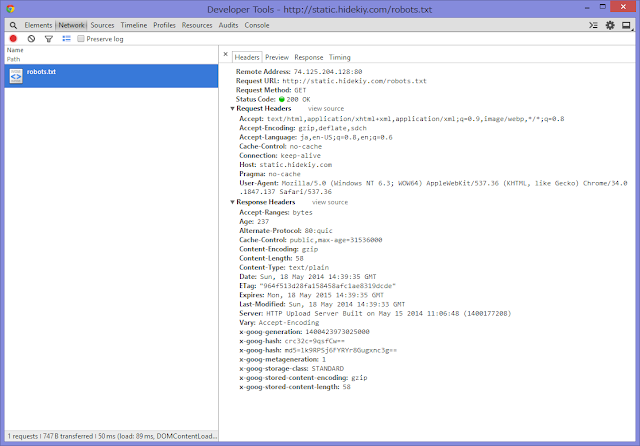

ブログの静的ファイルの配信を Amazon S3 + CloudFront の構成から、 Google Cloud Storage へ移行してみました。Google Cloud Storage の方は単体で CDN 付なのでオブジェクトの ACL を一般公開設定にするだけで CDN 部分の設定が不要なのが便利です。 具体的には、Cloud Storage のコンソールで配信したいドメイン名でバケットを作成し、CNAME を c.storage.googleapis.com に向ければよいです。ドットを含む名前でバケットを作成する際は、それがドメインの所有権の確認が済んでいるドメイン以下である必要があるみたいです。 Bucket and Object Naming Guidelines - Google Cloud Storage 準備 Web UI はありますが細かい設定をしようとすると現時点では1ファイルずつしか設定できないので、速やかにCLIツールをインストールすることをお勧めします。 使用するコマンドは gsutil (Google Storage Util?) で、これのみインストールする方法もありますが gcloud コマンドからインストールすると自動更新対象になって良いと思います。gcloud コマンドのインストールは、 Google Cloud SDK Quick Start で、インストール中にお勧めされるがままに進めると自動で gsutil も使用可能になると思います。 コマンド集 # バケット一覧 gsutil ls # ヘルプ gsutil help cp # ファイルをアップロード gsutil cp SRC DEST # ディレクトリをアップロード gsutil cp -r SRC_DIR DEST # 今回アップロード時に使ったコマンド gsutil -h "Cache-Control: public,max-age=31536000" cp -a public-read -z js,css,txt,html -r SRC_DIR gs://static.hidekiy.com/1/ setmeta が遅い オブジェクトの新規作成 cp に比べてメタデータ (HTTP ヘッダ